По мере развития технологий обработки текста всё больше хедж-фондов используют анализ настроений на основе обработки естественного языка для принятия мгновенных решений по акциям и другим активам. Теперь два исследователя из Цюрихского университета показали, как можно манипулировать этими алгоритмами с помощью состязательной атаки.

Айсун Кан Туреткен и Маркус Лейппольд использовали Financial Phrase Base и другие широко используемые учебные наборы данных, чтобы научить chatGPT и BERT интерпретировать настроения в типичных фразах и выражениях, используемых в финансовых новостях. Результатом стали две небольшие языковые модели, специализированные и обученные читать финансовые новости и классифицировать их как позитивные, нейтральные или негативные.

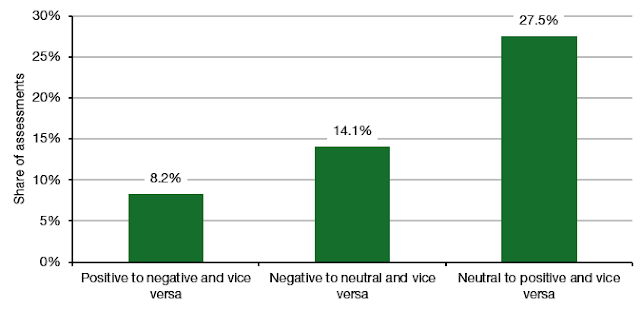

Затем они попытались «взломать» эти автоматизированные модели настроений, слегка изменив предложения. Если всё было сделано правильно, они могли перевернуть оценку небольших языковых моделей с нейтральной на положительную, с нейтральной на отрицательную или даже с положительной на отрицательную. На диаграмме ниже показаны средние результаты для этой финансовой модели GPT для трёх использованных наборов данных.

Доля оценок, измененных из-за взлома:

Источник: Туреткен и Лейппольд (2025).

Обычно взломы могут перевернуть оценку настроений примерно в 40% случаев и снизить точность оценки настроений примерно на 20%. Другими словами, алгоритмы, которые используют такие модели для зарабатывания денег, столкнутся с большим снижением прибыльности (и потенциально полной потерей прибыльности).

Если вы хотите узнать, насколько большими или, скорее, насколько малыми должны быть эти изменения в предложениях, чтобы модели тональности дали иную оценку, вот несколько примеров.

Примеры выявленных уязвимостей:

Источник: Туреткен и Лейппольд (2025).

На практике сложно «взломать» алгоритм хедж-фонда, используя эти модели настроений на естественном языке, поскольку они обычно питаются реальными данными в X или новостными лентами из официальных источников. Взлом этих моделей затем потребует взлома потока данных этих хедж-фондов.

Однако с практической точки зрения этот эксперимент показывает, что эти алгоритмически управляемые модели невероятно чувствительны к небольшим изменениям в языке, используемом журналистами Bloomberg, WSJ, FT и т. д. Возможности для ошибок велики, и я думаю, что именно это многие инвесторы в настоящее время недостаточно оценивают.

И затем мы должны принять во внимание, что всё больше и больше финансовых новостей создаётся самими LLM. В настоящее время, если вы читаете новостную статью Bloomberg в торговом терминале, то, по сути, автоматически получаете ИИ-резюме оригинального текста. Насколько я могу судить, никто не проверяет содержание этих ИИ-резюме перед публикацией в ленте терминала. Результатом является то, что ИИ-модели естественного языка всё чаще реагируют на новостные сообщения, написанные теми же ИИ. К чему мы придём, покажет время. Удачи!!!

_______________________________________________________________________________________________________________________

Помогая проектам ТТ, где есть Большое Спасибо:

Для РФ: МИР: 2200700155277048

Донаты для ТТ в крипте:

BTC: bc1qtr4c0v8uh95eppzcz93az7plvhcewv4hmqwcav

ETH: 0xDdf2a1fC12bf01493979A9e5179bAD7702F9c6A3

USDT: 0xDdf2a1fC12bf01493979A9e5179bAD7702F9c6A3

LTC: LhPwsfm1YhNcdF5fTobXsMYjuEsdpvgT46

SOL: C4hpFMHQFzCVX4BdXzTyHDDo7gk3XHzXGFXWndesR4

TON: UQDfuCbQs5NGOx5yJKk8KsDjM8LsFhLtqRgDJi5ShOTeWZxy

Комментариев нет:

Отправить комментарий